distiluse-base-multilingual-cased-v1 windows手动下载

时间:2023-05-24 来源:网络 人气:

自媒体文章:2023年05月24日

在当今信息爆炸的时代,人工智能技术的快速发展也为我们带来了更多方便和效率。而在这些技术中,NLP(自然语言处理)是应用最为广泛的一种。而distiluse-base-multilingual-cased-v1就是其中一个比较优秀的模型,本文将详细介绍这个模型以及如何在Windows系统上手动下载它。

一、distiluse-base-multilingual-cased-v1简介

distiluse-base-multilingual-cased-v1是一种预训练的、多语言的NLP模型。它基于Google提出的BERT模型,经过了大量的训练和优化,并且已经在多个自然语言处理任务中取得了不错的效果。该模型支持超过50种语言,并且可以完成很多自然语言处理任务,如文本分类、命名实体识别、情感分析等。

二、手动下载distiluse-base-multilingual-cased-v1

由于distiluse-base-multilingual-cased-v1比较大,如果直接从HuggingFace下载可能会比较慢。因此,在Windows系统上手动下载可能会更快。

以下是手动下载步骤:

步骤1:访问HuggingFace模型页面。在distiluse-base-multilingual-cased-v1页面上,单击“Download”按钮。

步骤2:从弹出的对话框中选择“Saveas”选项,并将文件保存到您想要的位置。

步骤3:下载完成后,您需要将文件解压缩。可以使用7-Zip等工具来完成这个任务。

步骤4:解压缩后,您会看到一个名为“pytorch_model.bin”的文件。这就是distiluse-base-multilingual-cased-v1模型的权重文件。

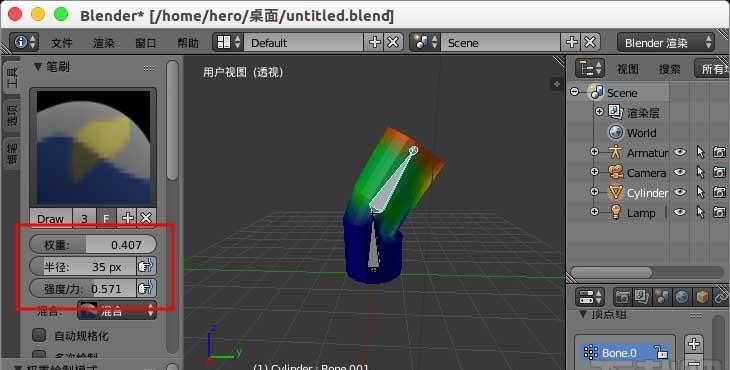

三、使用distiluse-base-multilingual-cased-v1

如果您想在Python中使用distiluse-base-multilingual-cased-v1模型,可以使用HuggingFace提供的transformers库。下面是一个简单的示例:

fromtransformersimportpipeline,AutoTokenizer,AutoModel

tokenizer=AutoTokenizer.from_pretrained("distiluse-base-multilingual-cased-v1")

model=AutoModel.from_pretrained("distiluse-base-multilingual-cased-v1")

text="你好,世界!"

inputs=tokenizer(text,return_tensors="pt")

outputs=model(**inputs)

print(outputs.last_hidden_state)

以上代码将输出文本“你好,世界!”的向量表示。

四、总结

distiluse-base-multilingual-cased-v1是一种非常有用的NLP模型。在Windows系统上手动下载它并不困难,并且可以更快地获得模型权重文件。如果您需要使用它,可以使用HuggingFace提供的transformers库来完成这个任务。

希望通过本文的介绍,您能够更好地了解distiluse-base-multilingual-cased-v1,并且在自然语言处理任务中获得更好的效果。

imtoken最新版:https://cjge-manuscriptcentral.com/software/3503.html

相关推荐

教程资讯

教程资讯排行

系统教程

-

标签arclist报错:指定属性 typeid 的栏目ID不存在。